3dmetria

Художественная среда в 3D графике!

Улучшение 3D-визуализаций с помощью ИИ Stable Diffusion

Всем привет! Я Виктор Престая, и последние 10 лет я занимаюсь визуализациями интерьеров и экстерьеров. Сегодня я хотел бы рассказать о том, как можно улучшить 3D-рендеры с помощью Stable Diffusion.

Stable Diffusion обычно используется через интерфейс Automatic 1111 — одну из самых популярных и удобных платформ. Она позволяет генерировать изображения по текстовым описаниям, а также работать напрямую с вашими рендерами с помощью режимов Img2img и Img2img Inpaint.

Более подробное объяснение того, что такое модели, Img2img, Inpaint и VAE, вы можете посмотреть в этом видео:

так же тут не много информации:

Помимо Stable Diffusion, существуют и другие нейросети, такие как Invoke или ComfyUI, и вы можете выбрать ту, которая лучше всего подходит под ваш рабочий процесс.

Как 3D-визуализаторы, мы часто тратим много времени на добавление людей в рендеры. Для средних и дальних планов мы обычно используем 3D-сканы, а для крупных планов вставляем вырезанных персонажей (cutout people).

С помощью режима Inpaint в Stable Diffusion мы можем доработать 3D-сканы людей на переднем плане и сделать их более реалистичными. При необходимости можно даже улучшить вырезанные фигуры.

Например, на переднем плане были использованы 3D-сканы людей, которые затем были доработаны с помощью режима Inpaint. Тот же подход можно применить к таким элементам, как огонь, дерево, бетон и другим, что позволяет сэкономить время на детальной обработке непосредственно в 3ds Max.

В следующем примере были улучшены два 3D-скана, а также вырезанные изображения кошки и мыши вместе с их материалами.

Чтобы сохранить творческий контроль и оставаться максимально близким к исходной задумке, вы можете использовать модели ControlNet, которые обеспечивают беспрецедентный уровень точности при работе с изображениями. Подробнее об этом вы можете узнать в этом видео:

так же и тут можно посмотреть:

Самыми полезными моделями являются Canny и Line Art, которые помогают управлять формами. Canny лучше всего работает с контурами, а Line Art — с остальными элементами. Их также можно комбинировать.

Также стоит обратить внимание на функцию SD Upscale в Stable Diffusion:

так же и тут:

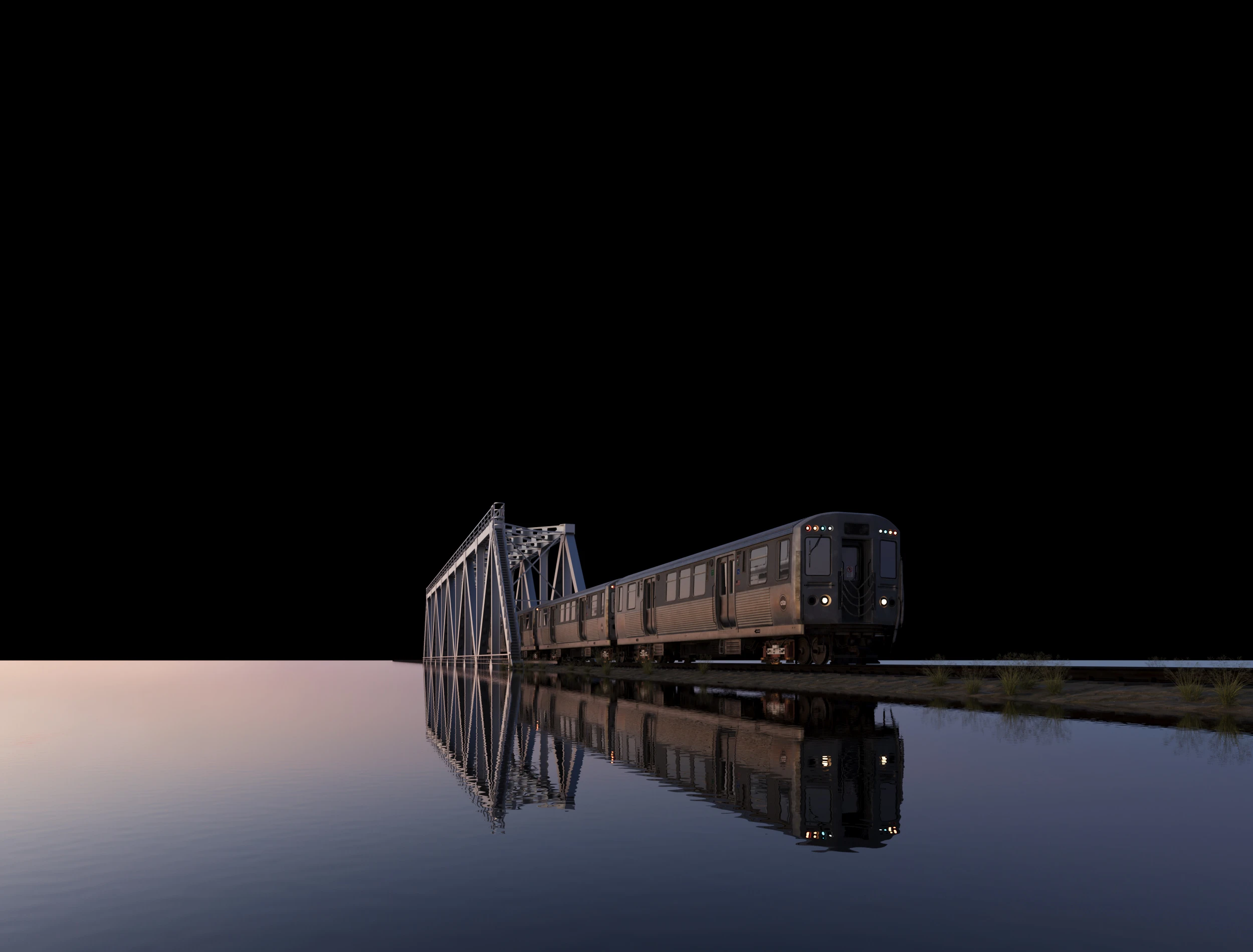

С помощью этих новых инструментов мы можем тратить меньше времени на технические детали и больше сосредотачиваться на креативе. Например, можно начать с базового рендера, немного доработать его в Photoshop, а затем улучшить в Stable Diffusion.

Хотя волшебной кнопки, которая сделает всё за нас, пока не существует — режим Inpaint всё ещё может занимать много времени, требуя хорошо подготовленного исходного изображения и нескольких прогонов для получения нужного результата — это всё же быстрее, чем создавать всё с нуля в 3D.

Одно можно сказать точно: будущее будет захватывающим и непредсказуемым. Нейросети принесут серьёзные изменения в наш рабочий процесс. Уже сегодня они могут помогать нам с референсами, идеями, доработкой рендеров и даже созданием видео.

Спасибо за внимание! Рад поделиться своим опытом. Подробнее о моих работах вы можете узнать в моём профиле на Behance: https://www.behance.net/3d_ellesare41c

___________________________

АВТОР: Viktor Prestaya

ИСТОЧНИК: cgaward.com.ua